أطلق أحد أعضاء مجلس جوجل الاستشاري الجديد لتطوير الذكاء الاصطناعي تحذيرًا شديدًا في وقت نترقب فيه انعقاد أول مؤتمر للمجلس.

ونقلت صحيفة جنوب الصين، عن دي كاي، عالم هندسة الحواسيب في جامعة هونج كونج للعلوم والتقنية وأحد ثمانية أسماء أعلنت عنها جوجل لتشكيل المجلس الجديد، أن «الذكاء الاصطناعي يمثل أكبر قوة تدميرية تواجهها البشرية على الإطلاق، ويقلقني تصاعد وتيرة النقاشات حول الموضوع، ونقترب الآن من حقبة يمكن للناس فيها إنتاج أسلحة خطيرة بسهولة مثل أساطيل الطائرات المسلحة دون طيار- لم يعد الأمر سرًا بعد الآن.

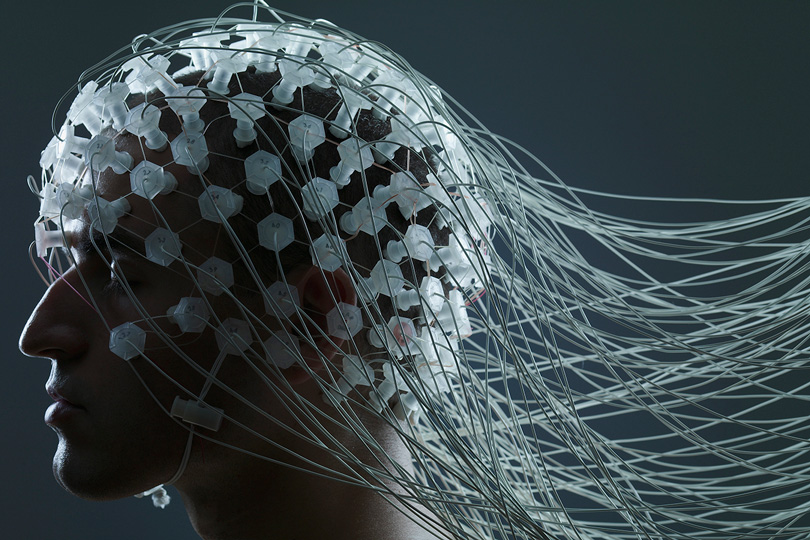

ولطالما كانت احتمالية تطوير الذكاء الاصطناعي لآليات تفكير خاصة للوصول إلى مراحل متقدمة تشابه البشر مثار جدل في أوساط العلماء والفلاسفة وعدها كثيرون ضربًا من شطحات الخيال العلمي لنصل في عصرنا الراهن إلى إرهاصات أولى لهذا التوجه الجديد للآلات.

ويتطلب التعلم العميق للآلات بنية معقدة تحاكي الشبكات العصبونية للدماغ البشري، بهدف فهم الأنماط، حتى مع وجود ضجيج، وتفاصيل مفقودة، وغيرها من مصادر التشويش. ويحتاج كمية كبيرة من البيانات وقدرات حسابية هائلة، توسع قدرات الذكاء الاصطناعي للوصول إلى التفكير المنطقي، ويكمن ذلك في البرنامج ذاته؛ فهو يشبه كثيرًا عقل طفل صغير غير مكتمل، ولكن مرونته لا حدود لها.

ولا يخفي خبراء الذكاء الاصطناعي مخاوفهم من تنامي اعتماد البشرية على خوارزمياته وتطوير التعلم العميق للآلات ووصوله إلى قدرات غير مسبوقة من السيطرة والتلاعب بالمجتمعات، على الرغم من إيجابيات الذكاء الاصطناعي المتطور وقدرته على تحسين العالم ومكافحة الأمراض ورفع مستويات الرعاية الصحية وتخليصنا من مهام عبودية تهيمن على حياتنا.

استخدامات شريرة

وقال العالِم كينث ستانلي لمرصد المستقبل _المدير الهندسي لمخابر أوبر للذكاء الاصطناعي_ إن «أكثر الأمور مدعاة للقلق، استخدام الذكاء الاصطناعي لإيذاء البشر، مع وجود تطبيقات كثيرة تجعلك تتخيل حدوث ذلك، ويجب علينا أن نكون أكثر حذرًا، وأن لا نسمح لهذا الجانب السيئ بالخروج. إن فهم كيفية استمرار ثقتنا بالذكاء الاصطناعي، هو سؤال صعب جدًا وله أبعاد كثيرة تتجاوز الأبعاد العلمية، ما يُبرز الحاجة الملحة لمشاركة المجتمع كله في الإجابة عليه.

وأضاف في لقاء خاص مع مرصد المستقبل إن «إساءة استخدام جميع أنواع التقنية أمر وارد، وأظن أن الذكاء الاصطناعي ليس إلا مثالًا آخر على ذلك، ولطالما كافح البشر لمنع استخدام التقنيات الحديثة لأغراض شريرة، ويبقى إقدامنا على وضع ضوابط وضمانات صحيحة، كفيلًا بجعلها آمنة. لا يمكنني الجزم اليوم بشأن قدرتنا على ضبط الأمور مستقبلًا، وما يجب أن نفعله حيال ذلك، لكن يمكنني أن أحذر من آلية التعاطي مع الذكاء الاصطناعي، وضرورة اتخاذ جانب الحيطة خلال استجابتنا لتأثيراته، وأن نطور طرائق تعاملنا معه بالتدريج.»

وقال إيركلي بيريدز، رئيس مركز الذكاء الاصطناعي والروبوتي في معهد الأمم المتحدة الأقاليمي لبحوث الجريمة والعدالة، في حديث خاص لمرصد المستقبل، إن «أكثر الأمور خطورة في الذكاء الاصطناعي، هو التطور السريع، فقد نتعرض لمشاكل جراء فقدان التوازن بين سرعة تطور الذكاء الاصطناعي وسرعة قابليتنا للتكيف معها.

الخطر يكمن في سوء الاستخدام

في حين يرى آخرون أن الخطر لا يعود للذكاء الاصطناعي بحد ذاته، بل يكمن في سوء الاستخدام؛ وقال الباحث هافا سيجلمان، مدير برامج تقنية الأنظمة الميكروية في وكالة مشاريع بحوث الدفاع المتطورة (داربا) التابعة لوزارة الدفاع الأمريكية، لمرصد المستقبل، إن «جميع أنواع التقنية قابلة لسوء الاستخدام. أظن أن الأمر بيد من يستخدمها. ولا وجود لتقنية سيئة، بل أشخاص سيئون.»

وقال توماس ميكولوف، عالم أبحاث الذكاء الاصطناعي في شركة فيسبوك «عند توفر اهتمام كبير وتمويل ضخم حول شيء معين، يظهر أشخاص مستعدون لإساءة استخدامه. وما يثير القلق هو إقدام بعض الأشخاص على بيع الذكاء الاصطناعي قبل صنعه حتى، مدَّعين معرفة ماهية المشكلة التي سيحلها.» وأضاف إن «شركات ناشئة تطلق وعودًا عن أشياء تعتبرها من أمثلة الذكاء الاصطناعي الرائعة، إذ تتفنن أنظمتها في تطوير مسار واحد، قد لا يكون مثار اهتمام أحد، وتقضي عشرات الآلاف من ساعات العمل لتحسين قيمة وحيدة، ثم تدعي بعد ذلك بأنها قامت بإنجاز ضخم وتسوق ادعاءات كبيرة بأنها أتت بما لم يسبقها إليه أحد.»

ولسنا متيقنين بعد من إمكانية إنشاء ذكاء اصطناعي عام قادر على أداء أي مهمة إدراكية يستطيع البشر القيام بها ببراعة أو ربما بشكل أفضل.

وعلى الرغم من المستقبل الواعد للذكاء الاصطناعي المتقدم، إلا أنه يظل مقرونًا بجملة من الإشكاليات والأسئلة الأخلاقية، وربما لا نعرف جميع الأسئلة التي يجب الإجابة عنها حتى الآن.

اضافةتعليق

التعليقات